Die EU will KI-Technologien regulieren und damit potenzielle Auswirkungen auf einzelne Personen, die Gesellschaft und die Wirtschaft steuern - zugleich soll ein attraktives innovationsfreundliches Umfeld entstehen.

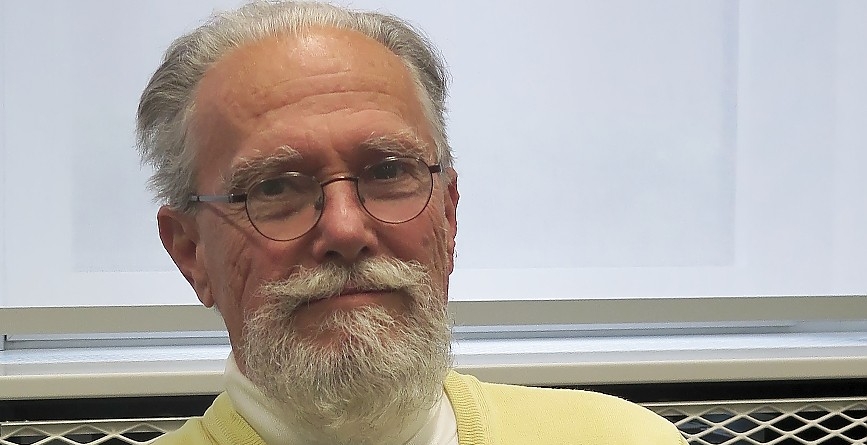

„Bei den ethischen Standards für Künstliche Intelligenz geht es in erster Linie darum, Transparenz und Datensicherheit herzustellen und die Grundrechte der europäischen Bürger*innen zu wahren“, erklärt der Digitalexperte der EVP-Fraktion im EU-Parlament, Axel Voss. Dazu brauche man entsprechende Aufsichtsmechanismen. Kürzlich habe das Europäische Parlament einen Initiativbericht zu zivilrechtlicher Haftung bei Künstlicher Intelligenz verabschiedet, bei dem Voss Berichterstatter war. Damit soll der digitale Binnenmarkt harmonisiert und eine Balance zwischen Rechtssicherheit und Raum für Innovation ermöglicht werden.

Der europäische Rahmen für die zivilrechtliche Haftung habe sich bewährt und müsse durch das Aufkommen von KI-Systemen nun nicht neu erfunden werden. „Das Ziel unserer Vorschläge ist es vielmehr, eine potenzielle Rechtslücke zu schließen, indem wir die Betreiber risikoreicher KI-Systeme für den Schaden haftbar machen, den ihre Anwendungen verursachen.“ Dabei werde zwischen Hochrisiko- und allen anderen KI-Systemen unterschieden. Nur die Hochrisiko-Systeme sollen, nach sorgfältiger Auswahl durch die EU-Kommission in enger Zusammenarbeit mit Interessenvertretern aus Wissenschaft, Wirtschaft und der Zivilgesellschaft, einer Gefährdungshaftung unterliegen.

Die Grüne Europaabgeordnete Alexandra Geese verweist in diesem Zusammenhang auf Rechtsunsicherheit in vielen Bereichen und Rechtslücken: „Es gibt ein berüchtigtes Beispiel aus den USA, wo Künstliche Intelligenzen die Rückfallwahrscheinlichkeit von Straftäter*innen berechnet haben, um daran gemessen Bewährungsstrafen festzulegen.“ Dort würden schwarze Menschen strukturell diskriminiert, weil das Computersystem mit den zur Verfügung stehenden Daten gearbeitet habe, die schon in sich von Diskriminierungen geprägt seien. In einem solchen Fall bestehe kein zivilrechtlicher Haftungsanspruch, da das Computersystem ja korrekt mit allen zur Verfügung stehenden – wenngleich diskriminierenden – Daten arbeite und damit nicht "fehlerhaft" im Sinne des aktuellen Haftungsregimes sei. „Wir brauchen deshalb eine sogenannte Gefährder*innenhaftung, ähnlich wie wir es aus dem Straßenverkehr für den Betrieb von Kraftfahrzeugen kennen: Betreiber*innen einer Künstlichen Intelligenz müssen verschuldensunabhängig für risikoreiche Anwendungen haften.“

„Selbstverständlich muss es auch Haftungssysteme geben, wenn bei Künstlicher Intelligenz etwas schiefgeht“, bestätigt Prof. Dr. Antonio Krüger, Geschäftsführer des Deutschen Forschungszentrum für Künstliche Intelligenz GmbH (DFKI). Der Forscher glaubt allerdings, dass die bestehenden Regeln ausreichen. Sowohl die Betreiber als auch die Produzenten von solchen Systemen seien grundsätzlich für ihr Tun verantwortlich. Abhängig vom Kontext und dem Einsatz von KI gebe es bereits spezielle Regeln, etwa in bestimmten Produktbereichen. Möglicherweise gebe es im Einzelfall tatsächlich Anpassungsbedarf, etwa im Bereich der Medizintechnik. „Doch grundsätzlich sehe ich keinen besonderen neuen Regelungsbedarf, weil der bestehende Rechtsrahmen ausreicht.“

Er plädiert ganz grundsätzlich für strikte Regeln „die auf eine menschenzentrierte Künstliche Intelligenz abzielen – als Alternative zu der Art und Weise, wie Künstliche Intelligenz in den USA oder in China betrieben wird.“ Bei der Datenschutzgrundverordnung habe man beobachten können, welchen Einfluss eine Regulierung haben kann, die konträr zu der in China und auch in den USA ist. „Die großen Internetkonzerne haben die EU-Regeln in anderen Teilen der Welt wie in Afrika und Südamerika zu großen Teilen übernommen.“ Denn am Ende sei es für die globalen Konzerne einfacher und kosteneffizienter, strengere Regeln weltweit zu implementieren, als für jeden Markt eigene Lösungen zu entwickeln.

Solche Regulierungsformen können für Prof. Dr. Regina Ammicht Quinn, Sprecherin des Internationalen Zentrums für Ethik in den Wissenschaften (IZEW) an der Universität Tübingen, ein Wettbewerbsvorteil und ein Vorteil für ein Gleichgewicht zwischen Politik, Bürgern und Wirtschaft sein. Sie verweist darauf, dass zwar eine große Einigkeit darüber herrscht, dass beispielsweise Fairness bzw. Gerechtigkeit oder Verantwortlichkeit „gut“ sind Indes beaobachtet sie, dass nicht alle das gleiche Ziel auch mit gleichen Mitteln verfolgen wollen – "oder nicht alle wollen ein sinnvolles Ziel verfolgen, wenn es zu schwierig, komplex oder aufwändig zu erreichen ist".

Carla Hustedt von der Bertelsmann Stiftung drängt auf mehr Transparenz beim Einsatz algorithmischer Systeme. „Betroffene müssen etwa darüber informiert werden, wenn eine Maschine über sie entscheidet. Weiterhin müssen diese Entscheidungen verständlich gemacht und Beschwerdemechanismen eingerichtet werden.“ Regulierung alleine werde nicht ausreichen, um die Risiken der Technologie zu begrenzen und ihre Chancen für das Gemeinwohl auszunutzen. Es brauche ein Ökosystem der KI-Ethik, mit einer großen Vielfalt an Maßnahmen. So müssen aus Sicht der Expertin für Ethik der Algorithmen die Diversität im Tech-Sektor gefördert und digitale zivilgesellschaftliche Akteure gestärkt werden. Außerdem brauche es dringend einen Kompetenzaufbau bei Staat und Gesellschaft.

Aus Sicht von Jason Chumtong, KI-Experte bei der Konrad-Adenauer-Stiftung, sollten die mit KI einhergehenden Risiken nicht unterschätzen werden, doch sie erfordern keine neuen ethischen Standards. Wenn beispielsweise bei Personalauswahl KI im Spiel sei, gehe es um die Aufrechterhaltung von Gleichheit und faire Chancen für jeden Menschen, also ethischen Standards, die auch in anderen Bereichen selbstverständlich. Daher müssten vor allem heute bereits gültige Standards auch bei der Nutzung von KI weiterhin durchgesetzt werden. Michael Mörike, Vorstand der Integrata-Stiftung für humane Nutzung der Informationstechnologie, will über ethische Standards hinaus gehen und Moral in die Maschinen selbst einbauen. „Das wird nicht nur eine große Herausforderung, sondern auch ein großer Markt, den andere bisher noch nicht angegangen sind.“